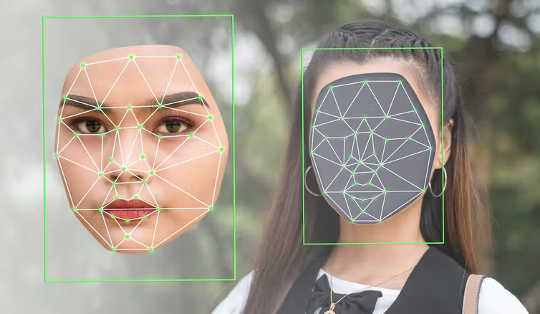

فناوری که می تواند دیپ فیک تولید کند به طور گسترده ای در دسترس است. (Shutterstock)

در اوایل ماه مارس، یک ویدئوی دستکاری شده ولودیمیر زلنسکی، رئیس جمهور اوکراین منتشر شد. در آن، یک Zelenskyy به صورت دیجیتالی به ارتش ملی اوکراین گفته بود که تسلیم شوند. این ویدیو به صورت آنلاین منتشر شد اما به سرعت به عنوان یک دیپ جعلی از بین رفت - یک ویدیوی فوق واقعی و در عین حال جعلی و دستکاری شده که با استفاده از هوش مصنوعی تولید شده است.

در حالی که به نظر می رسد اطلاعات نادرست روسیه تأثیر محدودی دارد، این مثال هشدار دهنده عواقب بالقوه دیپ فیک را نشان می دهد.

با این حال، دیپ فیک با موفقیت در فناوری کمکی استفاده می شود. برای مثال، افرادی که از بیماری پارکینسون رنج می برند می توانند از شبیه سازی صدا برای برقراری ارتباط استفاده کنند.

Deepfakes در آموزش استفاده می شود: شرکت سنتز گفتار مستقر در ایرلند CereProc یک صدای مصنوعی برای جان اف کندی ایجاد کرد. او را برای ایراد سخنرانی تاریخی خود به زندگی بازگرداند.

با این حال هر سکه دو روی دارد. دیپ فیک می تواند بیش از حد واقعی باشد، و اساساً توسط چشم انسان قابل تشخیص نیست.

بنابراین، از همان فناوری شبیه سازی صدا می توان برای فیشینگ، افترا و باج خواهی استفاده کرد. هنگامی که دیپ فیک عمداً برای تغییر شکل افکار عمومی، تحریک درگیری های اجتماعی و دستکاری در انتخابات به کار می رود، پتانسیل تضعیف دموکراسی را دارد.

محققان دانشگاه واشنگتن یک دیپ فیک از باراک اوباما تهیه کردند.

ایجاد هرج و مرج

دیپ فیک بر اساس فناوری شناخته شده است شبکه های نژادی مولد که در آن دو الگوریتم یکدیگر را برای تولید تصاویر آموزش می دهند.

در حالی که فناوری پشت جعلی های عمیق ممکن است پیچیده به نظر برسد، تولید آن کار ساده ای است. برنامه های آنلاین متعددی مانند تعویض چهره و ZAO Deepswap که می تواند در عرض چند دقیقه دیپ فیک تولید کند.

Google Colaboratory - یک مخزن آنلاین برای کد در چندین زبان برنامه نویسی - شامل نمونه هایی از کد است می تواند برای تولید تصاویر و فیلم های جعلی استفاده شود. با این نرم افزار در دسترس، به راحتی می توان مشاهده کرد که چگونه کاربران معمولی می توانند بدون درک خطرات امنیتی بالقوه با دیپ فیک ویران کنند.

محبوبیت برنامه های تعویض چهره و خدمات آنلاین مانند نوستالژی عمیق نشان می دهد که چگونه به سرعت و به طور گسترده ای دیپ فیک می تواند توسط عموم استفاده شود. در سال 2019، تقریباً 15,000 ویدیو با استفاده از دیپ فیک شناسایی شد. و انتظار می رود این تعداد افزایش یابد.

دیپ فیک ابزاری عالی برای کمپین های اطلاعات نادرست است زیرا اخبار جعلی قابل باوری تولید می کند که افشای آن زمان می برد. در همین حال، آسیب های ناشی از دیپ فیک - به ویژه آنهایی که بر شهرت افراد تأثیر می گذارد - اغلب طولانی مدت و غیرقابل برگشت هستند.

DeepSwap یک انتخاب عالی برای هر کسی است که میخواهد با حداقل تلاش، دیپفیکهای متقاعدکننده ایجاد کند. ??t;a href="https://twitter.com/hashtag/DeepSwap?src=hash&ref_src=twsrc%5Etfw">#DeepSwap #تعویض چهره #DeepFake #FaceApp #بازنمایی #مرور # مرورها # هوش مصنوعی #AI #Tech #فن آوری # فناوری_نیوز #اخبار فناوری #منا #TechMGZNhttps://t.co/A2Cbp02sH1

— مجله فناوری (@TechMGZN) ممکن است 4، 2022

آیا دیدن ایمان است؟

شاید خطرناکترین پیامد دیپفیکها این باشد که چگونه خود را به اطلاعات نادرست در مبارزات سیاسی میرسانند.

ما این را زمانی دیدیم که دونالد ترامپ هرگونه پوشش رسانه ای نامطلوب را به عنوان "اخبار جعلی" ترامپ با متهم کردن منتقدان خود به انتشار اخبار جعلی، توانست از اطلاعات نادرست در دفاع از اقدامات اشتباه خود و به عنوان یک ابزار تبلیغاتی استفاده کند.

استراتژی ترامپ به او اجازه میدهد در محیطی مملو از بیاعتمادی و اطلاعات نادرست با ادعای «حمایت» خود را حفظ کند.که رویدادها و داستان های واقعی اخبار جعلی یا دیپ فیک هستند"

اعتبار در مراجع و رسانه ها تضعیف می شود، ایجاد فضای بی اعتمادی. و با گسترش روزافزون دیپ فیک ها، سیاستمداران به راحتی می توانند مسئولیت هرگونه رسوایی در حال ظهور را انکار کنند. در صورت انکار، چگونه می توان هویت فردی را در یک ویدیو تایید کرد؟

با این حال، مبارزه با اطلاعات نادرست، همیشه چالشی برای دموکراسی ها بوده است، زیرا آنها تلاش می کنند از آزادی بیان حمایت کنند. مشارکت انسان و هوش مصنوعی میتواند به مقابله با خطر فزاینده دیپفیک با واداشتن افراد به تأیید اطلاعات کمک کند. معرفی قوانین جدید یا اعمال قوانین موجود برای مجازات تولیدکنندگان دیپ فیک به دلیل جعل اطلاعات و جعل هویت افراد نیز می تواند مورد توجه قرار گیرد.

رویکردهای چند رشته ای دولت های بین المللی و ملی، شرکت های خصوصی و سایر سازمان ها همگی برای محافظت از جوامع دموکراتیک در برابر اطلاعات نادرست حیاتی هستند.![]()

درباره نویسنده

سی فونگ لی، معاون پژوهشی، گروه مطالعات اطلاعات، دانشگاه مک گیل و بنجامین سی ام فانگ، پروفسور و کرسی تحقیقات کانادا در داده کاوی برای امنیت سایبری، دانشگاه مک گیل

این مقاله از مجله منتشر شده است گفتگو تحت مجوز Creative Commons دفعات بازدید: مقاله.