تصاویری از بازی جعلی میحیه آروم و فیلیپو Menczer

تصاویری از بازی جعلی میحیه آروم و فیلیپو Menczer

رسانه های اجتماعی از جمله هستند منابع اصلی اخبار در ایالات متحده و در سراسر جهان. با این حال، کاربران در معرض محتوای دقت متقابل هستند، از جمله تئوری های توطئه, کلیک کنید, محتوای هیپرپارتیسیان, علم شبه و حتی گزارش های جعلی "جعلی" ساخته شده است.

جای تعجب نیست که اطلاعات بسیار ناچیز منتشر شده است: هرزنامه و تقلب آنلاین برای مجرمان سود آور است، و عملکرد دولت و تبلیغات سیاسی هم مزایای پارتی و هم مالی. اما این واقعیت است که محتوای کم اعتبار به سرعت و به آسانی گسترش می یابد نشان می دهد که مردم و الگوریتم های پشت سیستم عامل های رسانه های اجتماعی به دستکاری آسیب پذیر هستند.

تحقیقات ما سه نوع از تعصب را شناسایی کرده است که اکوسیستم رسانه های اجتماعی آسیب پذیر به اطلاعات غلط و غلط اتفاقی است. به همین دلیل است که ما رصدخانه در رسانه های اجتماعی در دانشگاه ایندیانا در حال ساخت است ابزار برای کمک به مردم از این بی توجهی ها آگاه می شود و خود را از تأثیرات بیرونی که برای بهره برداری از آنها طراحی شده است، محافظت می کند.

توضیح ابزار توسعه یافته در رصدخانه در رسانه های اجتماعی:

{youtube}https://youtu.be/BIv9054dBBI{/youtube}

اختلال در مغز

تعصبات شناختی از طریق مغز اطلاعاتی را که هر فرد در هر روز با آن مواجه می شود، ایجاد می کند. مغز می تواند تنها با مقدار محدودی از اطلاعات مقابله کند و بسیاری از محرک های ورودی نیز می توانند ایجاد کنند بیش از حد اطلاعات. این به خودی خود پیامدهای جدی برای کیفیت اطلاعات در رسانه های اجتماعی دارد. ما دریافتیم که رقابت شدیدی برای توجه محدود کاربران به این معنی است که بعضی از ایده ها با وجود کیفیت پایین آنها ویروسی هستند - حتی زمانی که مردم ترجیح می دهند محتوای با کیفیت بالا را به اشتراک بگذارند.

برای جلوگیری از غرق شدن، مغز با استفاده از یک تعداد کلاهبرداریها. این روش ها معمولا موثر هستند، اما ممکن است تبدیل شدن به تعصب هنگامی که در زمینه های اشتباه استفاده می شود.

یک میانبر شناختی زمانی اتفاق می افتد که فرد تصمیم بگیرد که آیا یک داستان را که در خوراک رسانه های اجتماعی خود ظاهر می شود، به اشتراک بگذارد. مردم هستند توسط پیامدهای احساسی یک عنوان تحت تاثیر قرار می گیرد، حتی اگر این شاخص خوبی از دقت مقاله نباشد. خیلی مهمتر است که قطعه را نوشت.

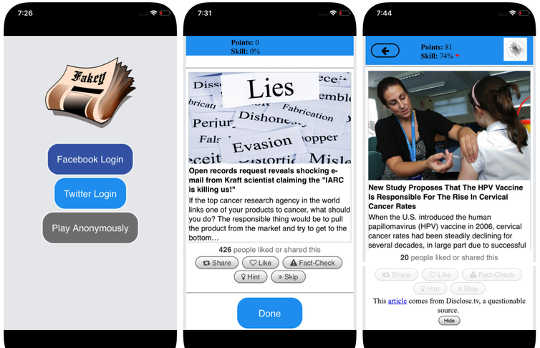

برای مقابله با این تعصب و کمک به مردم قبل از به اشتراک گذاشتن توجه بیشتر به منبع ادعا، ما توسعه دادیم جعلی، یک بازی سواد اطلاعاتی موبایل (رایگان در آندروید و IOS) شبیه سازی یک رسانه خبری معمولی رسانه های اجتماعی، با ترکیبی از مقالات خبری از منابع اصلی و معتبر پایین. بازیکنان امتیاز بیشتری برای به اشتراک گذاشتن اخبار از منابع معتبر و پرچم گذاری محتوای مشکوک برای بررسی واقعیت دریافت می کنند. در این فرایند، آنها یاد می گیرند سیگنال های اعتبار منبع، مانند ادعاهای hyperpartisan و سرفصل های هیجان انگیز متهم شوند.

اختلال در جامعه

منبع دیگری از تعصب از جامعه است. هنگامی که افراد به طور مستقیم با همسالان خود ارتباط برقرار می کنند، تعصب های اجتماعی که انتخاب خود را از دوستان هدایت می کنند، تاثیر می گذارد بر اطلاعاتی که می بینند.

در حقیقت، در تحقیق ما متوجه شدیم که این امکان وجود دارد تعیین اهداف سیاسی یک کاربر توییتر را تعیین کنید به سادگی به ترجیحات حزبی دوستانشان نگاه می کنند. تجزیه و تحلیل ما از ساختار این شبکه های ارتباطی خصوصی شبکه های اجتماعی کشف شده اند که در انتشار اطلاعات - دقیق یا غیرمستقیم - بسیار مفید هستند آنها از هم جدا شده و از دیگر نقاط جامعه جدا شده اند.

تمایل به ارزیابی اطلاعات بیشتر، اگر از درون محافل اجتماعی خود،اتاق اکو"که برای دستکاری، آگاهانه یا ناخواسته رسیده است. این کمک می کند توضیح دهد که چرا بسیاری از مکالمات آنلاین به تصویب رسید "ما در مقابل آنها" مقابله.

برای مطالعه اینکه چگونه ساختار شبکه های اجتماعی آنلاین باعث می شود کاربران آسیب پذیر به نادیده گرفتن، ما ساخته شده است هوشیار، یک سیستم که پخش و پخش محتوا را از منابع معتبر کم اعتبار می دهد و نحوه رقابت با محتوای واقعی را بررسی می کند. تجزیه و تحلیل ما از اطلاعات جمع آوری شده توسط Hoaxy در انتخابات ریاست جمهوری 2016 ایالات متحده نشان می دهد که حساب های توییتر که اطلاعات غلطی را به اشتراک گذاشتند، تقریبا به طور کامل قطع شده است از اصلاحات ساخته شده توسط چهره های واقعی.

هنگامی که ما بر روی حسابهای غرامدی گسترش یافتیم، گروهی از گروههای هسته ای بسیار متراکم را پیدا کردیم که تقریبا به طور انحصاری - از جمله چندین ربات خاص - به یکدیگر متصل می شدند. تنها زمانیکه سازمانهای بررسی واقعیت از کاربران در گروه غلط اطلاعات نقل شده یا ذکر شده بودند، وقتی مشکوک به مشروعیت خود بودند و یا مخالفت با آنچه که آنها نوشتهاید، مطرح میشدند.

اختلال در دستگاه

گروه سوم از تعصبات به طور مستقیم از الگوریتم های استفاده شده برای تعیین آنچه مردم آنلاین می بینند، بوجود می آیند. هر دو سیستم عامل رسانه های اجتماعی و موتورهای جستجو آنها را استخدام می کنند. این تکنولوژی های شخصی سازی طراحی شده اند تا تنها برای بیشتر کاربران جذاب و مناسب برای هر فرد انتخاب شوند. اما در انجام این کار، ممکن است موجب تقویت تعصبات شناختی و اجتماعی کاربران شود، به این ترتیب آنها را حتی برای دستکاری بیشتر آسیب پذیر می سازد.

به عنوان مثال، جزئیات ابزار تبلیغاتی ساخته شده در بسیاری از سیستم های رسانه های اجتماعی اعتراض كنندگان اطلاعات نادرست از آن بهره ببرند تمایل به تصدیق by خیاطی پیام ها به افرادی که قبلا به آنها اعتقاد دارند.

همچنین، اگر یک کاربر اغلب روی پیوندهای فیس بوک از یک منبع خبری خاص کلیک کند، فیس بوک خواهد شد تمایل دارد که این شخص را بیشتر از محتوای سایت ببیند. این به اصطلاح "حباب فیلتر"اثر ممکن است افراد را از دیدگاه های متنوع انزو کند، و تقویت تعصب تایید.

تحقیقات خود ما نشان می دهد که سیستم عامل های رسانه های اجتماعی، کاربران را به مجموعه های متنوع تر از منابع غیر از سایت های رسانه های غیر اجتماعی مانند ویکی پدیا قرار می دهد. از آنجا که این در سطح کل یک پلتفرم است و نه از یک کاربر تنها، ما این را می نامیم تعصب همگنی.

یکی دیگر از مهمترین عناصر رسانه های اجتماعی، اطلاعاتی است که براساس آنچه بیشترین کلیک را دریافت می کند، بر اساس پلتفرم است. ما این را می خواهیم تعصب محبوبیت، زیرا ما دریافتیم که یک الگوریتم طراحی شده برای ارتقاء محتوای محبوب ممکن است بر کیفیت کلی اطلاعات در پلتفرم تاثیر بگذارد. این همچنین به بی عدالتی شناختی موجود، تقویت آنچه که به نظر می رسد محبوب بدون در نظر گرفتن کیفیت آن است.

تمام این تعصبات الگوریتمی را می توان با استفاده از دستکاری کرد ربات های اجتماعیبرنامه های کامپیوتری که با استفاده از حساب های رسانه های اجتماعی با انسان ارتباط برقرار می کنند. بیشتر ربات های اجتماعی مانند توییتر ساعت بزرگی کهبر برج پارلمان لندن نصب شده است، بی ضرر هستند. با این حال، برخی از ماهیت واقعی خود را پنهان می کنند و برای اهداف مخرب مانند افزایش اطلاعات غلط یا نادرست ایجاد ظاهر یک جنبش مردمی، همچنین به نام "astroturfing" نامیده می شود شواهدی از این نوع دستکاری در پیش از انتخابات میان دوره ای 2010 ایالات متحده.

برای مطالعه این استراتژی های دستکاری، ما یک ابزار را برای شناسایی ربات های اجتماعی به نام توسعه دادیم بوتومتر. Botometer از یادگیری ماشین برای شناسایی حساب های ربات استفاده می کند، با بازرسی هزاران ویژگی مختلف حساب های توییتر، مانند زمان پست های آن، چگونگی پیوستن به آن ها و حساب های مربوط به آن و بازخوانی. این کامل نیست، اما نشان داده است که به عنوان بسیاری از 15 درصد حسابهای توییتر نشانه هایی از وجود ربات ها را نشان می دهد.

با استفاده از Botometer در رابطه با Hoaxy، هسته شبکه اطلاعات جاسوسی را در طول مبارزات انتخاباتی ریاست جمهوری 2016 مورد تحلیل قرار دادیم. ما بسیاری از رباتها را کشف کردیم که از پیش زمینه های شناختی، تایید و محبوبیت قربانیان و تعصبات الگوریتمی توییتر بهره می گیرند.

این ربات ها قادر به ایجاد حباب های فیلتر در اطراف کاربران آسیب پذیر هستند، آنها ادعا می کنند ادعاهای غلط و اطلاعات نادرست را دارند. اولا، آنها می توانند توجه کاربرانی که از یک نامزد خاص پشتیبانی می کنند با توجه به هشتگ های آن نامزد یا با ذکر و بازگرداندن شخص مورد توجه قرار گیرند. سپس رباتها می توانند ادعاهای دروغین را به مخالفان تحمیل کنند، با بازنویسی مقالات از منابع معتبر کم اعتبار که با کلمات کلیدی خاص مطابقت دارند. این فعالیت همچنین باعث می شود که الگوریتم برای سایر کاربران داستان های دروغین که به طور گسترده به اشتراک گذاشته می شود را برجسته کند.

درک آسیب پذیری های پیچیده

حتی به عنوان تحقیق ما و دیگران، نشان می دهد که چگونه افراد، موسسات و حتی کل جوامع می توانند در رسانه های اجتماعی دستکاری شوند، وجود دارد سوال های بسیار چپ به جواب این مهم است که کشف کنیم که چگونه این تعصب های مختلف با یکدیگر در تعامل هستند، به طور بالقوه آسیب پذیری پیچیده تر را ایجاد می کنند.

ابزارهایی مثل ما به کاربران اینترنت اطلاعات بیشتری در مورد نادیده گرفتن اطلاعات ارائه می دهند و به همین دلیل برخی از حفاظت از آسیب آن. راه حل ها به احتمال زیاد تنها تکنولوژیکی نیست، اما احتمالا بعضی از جنبه های فنی برای آنها وجود خواهد داشت. اما آنها باید در نظر بگیرند جنبه های شناختی و اجتماعی از مشکل

درباره نویسنده

جیووانی لوکا کیامپلاگیا، دانشمند معاون پژوهشی، موسسه علمی شبکه دانشگاه ایندیانا، دانشگاه ایندیانا و فیلیپو Menczer، استاد علوم کامپیوتر و رایانه؛ مدیر مرکز تحقیقات شبکه های مجتمع و سیستم ها دانشگاه ایندیانا

این مقاله در اصل در تاریخ منتشر شد گفتگو. دفعات بازدید: مقاله.

کتاب های مرتبط

at

با تشکر از بازدید شما InnerSelf.com، که در آن وجود دارد 20,000 + مقالههای تغییردهنده زندگی که «نگرشهای جدید و امکانات جدید» را تبلیغ میکنند. همه مقالات به ترجمه شده است بیش از 30 زبان. اشتراک به مجله InnerSelf که به صورت هفتگی منتشر می شود و الهام روزانه ماری تی راسل. مجله InnerSelf از سال 1985 منتشر شده است.

با تشکر از بازدید شما InnerSelf.com، که در آن وجود دارد 20,000 + مقالههای تغییردهنده زندگی که «نگرشهای جدید و امکانات جدید» را تبلیغ میکنند. همه مقالات به ترجمه شده است بیش از 30 زبان. اشتراک به مجله InnerSelf که به صورت هفتگی منتشر می شود و الهام روزانه ماری تی راسل. مجله InnerSelf از سال 1985 منتشر شده است.