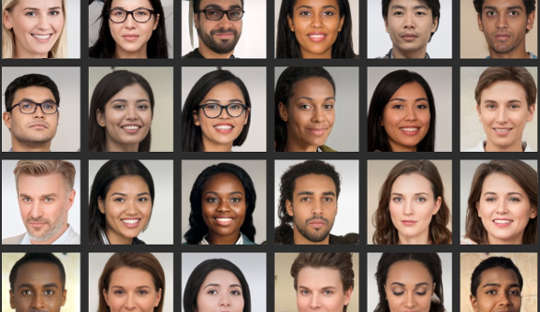

حتی اگر فکر می کنید در تجزیه و تحلیل چهره ها مهارت دارید، تحقیقات نشان میدهد بسیاری از مردم نمی توانند به طور قابل اعتمادی بین عکس های چهره های واقعی و تصاویری که توسط کامپیوتر تولید شده اند تمایز قائل شوند. این به ویژه اکنون مشکل ساز است که سیستم های کامپیوتری می توانند عکس هایی با ظاهر واقعی از افرادی که وجود ندارند ایجاد کنند.

اخیراً یک نمایه جعلی لینکدین با یک عکس پروفایل کامپیوتری خبرساز شده است ارتباط موفقیت آمیزی با مقامات آمریکایی و سایر افراد با نفوذ به عنوان مثال در بستر شبکه کارشناسان ضد جاسوسی حتی می گویند که جاسوسان به طور معمول پروفایل های فانتوم با چنین تصاویری را ایجاد می کنند. ورود به اهداف خارجی از طریق رسانه های اجتماعی.

این تقلبیهای عمیق در حال گسترش در فرهنگ روزمره هستند، به این معنی که مردم باید از نحوه استفاده از آنها در بازاریابی، تبلیغات و رسانههای اجتماعی آگاهی بیشتری داشته باشند. این تصاویر همچنین برای اهداف مخرب مانند تبلیغات سیاسی، جاسوسی و جنگ اطلاعاتی استفاده میشوند.

ساخت آنها شامل چیزی به نام شبکه عصبی عمیق است، یک سیستم کامپیوتری که روش یادگیری مغز را تقلید می کند. این با قرار دادن آن در معرض مجموعه داده های بزرگتر از چهره های واقعی "آموزش داده می شود".

در واقع، دو شبکه عصبی عمیق در مقابل یکدیگر قرار گرفته اند و برای تولید واقعی ترین تصاویر با هم رقابت می کنند. در نتیجه، محصولات نهایی به تصاویر GAN دوبله میشوند، جایی که GAN مخفف شبکههای متخاصم مولد است. این فرآیند تصاویر جدیدی تولید می کند که از نظر آماری از تصاویر آموزشی قابل تشخیص نیستند.

در مطالعه ما منتشر شده در iScience، ما نشان دادیم که عدم تشخیص این چهره های مصنوعی از چهره واقعی پیامدهایی برای رفتار آنلاین ما دارد. تحقیقات ما نشان میدهد که تصاویر جعلی ممکن است اعتماد ما را به دیگران کاهش داده و عمیقاً نحوه برقراری ارتباط آنلاین ما را تغییر دهد.

من و همکارانم دریافتیم که مردم چهرههای GAN را حتی واقعیتر از عکسهای واقعی از چهرههای واقعی مردم میدانند. در حالی که هنوز مشخص نیست چرا این اتفاق افتاده است، این یافته درست است پیشرفت های اخیر در فناوری را برجسته کنید برای تولید تصاویر مصنوعی استفاده می شود.

و همچنین یک پیوند جالب به جذابیت پیدا کردیم: چهره هایی که به عنوان جذابیت کمتر رتبه بندی شده بودند نیز به عنوان واقعی تر رتبه بندی شدند. چهره های کمتر جذاب را ممکن است معمولی تر در نظر بگیریم و چهره معمولی ممکن است به عنوان مرجع استفاده شود که همه چهره ها با آن ارزیابی می شوند. بنابراین، این چهرههای GAN واقعیتر به نظر میرسند زیرا بیشتر شبیه الگوهای ذهنی هستند که مردم از زندگی روزمره ساختهاند.

اما اصیل دیدن این چهرههای مصنوعی ممکن است پیامدهایی برای سطوح عمومی اعتمادی که به دایرهای از افراد ناآشنا گسترش میدهیم نیز داشته باشد - مفهومی که به عنوان «اعتماد اجتماعی» شناخته میشود.

ما اغلب در چهره هایی که می بینیم زیاد می خوانیم اولین برداشت هایی که ما ایجاد می کنیم، تعاملات اجتماعی ما را هدایت می کند. در آزمایش دومی که بخشی از آخرین مطالعه ما بود، دیدیم که مردم به احتمال بیشتری به اطلاعاتی که توسط چهرههایی که قبلاً واقعی بودنشان قضاوت کرده بودند، اعتماد میکنند، حتی اگر بهطور مصنوعی تولید شده باشند.

جای تعجب نیست که مردم به چهره هایی که معتقدند واقعی هستند اعتماد بیشتری می کنند. اما متوجه شدیم که وقتی مردم از حضور بالقوه چهرههای مصنوعی در تعاملات آنلاین مطلع شدند، اعتماد از بین رفت. آنها سپس سطوح پایین تری از اعتماد را به طور کلی نشان دادند - مستقل از واقعی بودن یا نبودن چهره ها.

این نتیجه میتواند از برخی جهات مفید تلقی شود، زیرا باعث میشود افراد در محیطی که ممکن است کاربران جعلی کار کنند مشکوکتر شوند. با این حال، از منظری دیگر، ممکن است به تدریج ماهیت نحوه ارتباط ما را از بین ببرد.

به طور کلی، ما تمایل به عمل داریم یک فرض پیش فرض مبنی بر اینکه افراد دیگر اساساً صادق و قابل اعتماد هستند. رشد پروفایل های جعلی و سایر محتوای آنلاین مصنوعی این سوال را ایجاد می کند که حضور آنها و دانش ما در مورد آنها چقدر می تواند این وضعیت "پیش فرض حقیقت" را تغییر دهد و در نهایت اعتماد اجتماعی را از بین ببرد.

در حال تغییر پیش فرض های ما

گذار به دنیایی که در آن آنچه واقعی است از آنچه نیست قابل تشخیص نیست، همچنین می تواند چشم انداز فرهنگی را از واقعی بودن در درجه اول به ساختگی و فریبنده بودن تغییر دهد.

اگر مرتباً صحت آنچه را که به صورت آنلاین تجربه میکنیم زیر سؤال میبریم، ممکن است از ما نیاز داشته باشد که تلاش ذهنی خود را از پردازش خود پیامها تا پردازش هویت پیامرسان دوباره به کار بگیریم. به عبارت دیگر، استفاده گسترده از محتوای آنلاین بسیار واقعی و در عین حال مصنوعی میتواند ما را ملزم به تفکر متفاوت کند – به روشهایی که انتظارش را نداشتیم.

در روانشناسی، ما از اصطلاحی به نام «نظارت بر واقعیت» برای اینکه چگونه به درستی تشخیص دهیم چیزی از دنیای بیرونی یا از درون مغزمان می آید، استفاده می کنیم. پیشرفت فناوریهایی که میتوانند چهرهها، تصاویر و تماسهای ویدیویی جعلی و در عین حال بسیار واقعی ایجاد کنند، بدین معناست که نظارت بر واقعیت باید بر اساس اطلاعاتی غیر از قضاوتهای خودمان باشد. همچنین خواستار بحث گستردهتری در مورد اینکه آیا نوع بشر هنوز هم میتواند از عهده حقیقت برآید یا خیر.

برای افراد بسیار مهم است که هنگام ارزیابی چهره های دیجیتال، انتقادپذیرتر باشند. این میتواند شامل استفاده از جستجوی عکس معکوس برای بررسی واقعی بودن عکسها، احتیاط در مورد نمایههای رسانههای اجتماعی با اطلاعات شخصی کم یا تعداد فالوورهای زیاد، و آگاهی از پتانسیل استفاده از فناوری دیپفیک برای مقاصد شرورانه باشد.

مرز بعدی برای این منطقه باید الگوریتم های بهبود یافته برای تشخیص چهره های دیجیتال جعلی باشد. سپس میتوان آنها را در پلتفرمهای رسانههای اجتماعی جاسازی کرد تا به ما در تشخیص چهرههای واقعی از جعلی در ارتباط با چهرههای جدید کمک کنند.

درباره نویسنده

مانوس تساکیریس، استاد روانشناسی، مدیر مرکز سیاست احساسات، دانشگاه سلطنتی هالووی لندن

این مقاله از مجله منتشر شده است گفتگو تحت مجوز Creative Commons دفعات بازدید: مقاله.